Temps de lecture : 5 minutesQu'est-ce que la déduplication des données et pourquoi s'en préoccuper ?

La quantité de données produites par les entreprises est en constante augmentation, et le taux de croissance ne ralentit pas. Au contraire, elle s'accélère. Mais qu'advient-il de toutes ces données ? Elles finissent par s'accumuler et remplir leur espace de stockage, ce qui ralentit les opérations et entraîne des coûts élevés. Si les entreprises ne trouvent pas un moyen efficace de gérer la croissance et le stockage des données, ces problèmes ne feront qu'empirer. Heureusement, la déduplication des données offre une solution rafraîchissante à la croissance galopante des données.

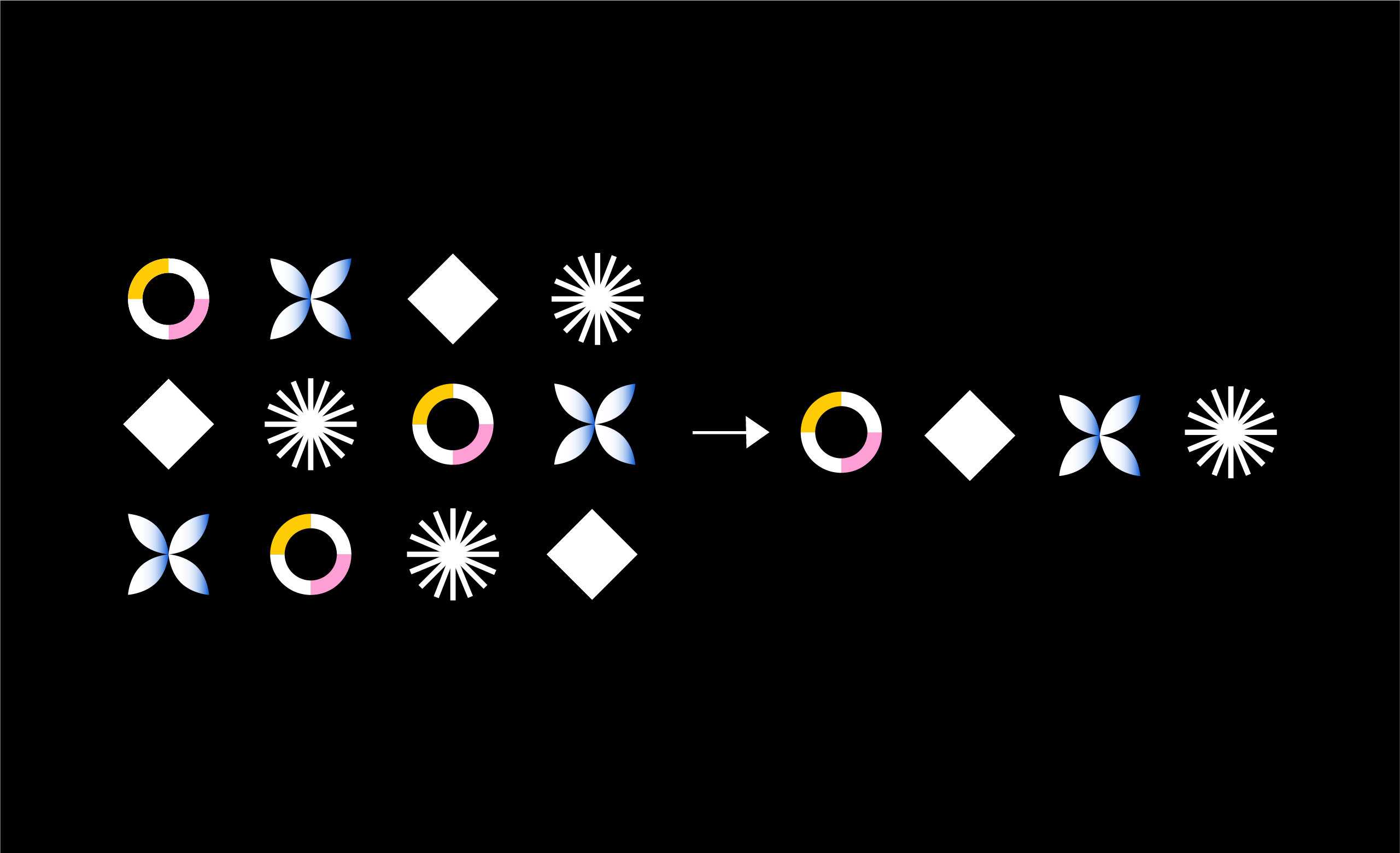

La déduplication des données réduit les besoins en capacité de stockage en éliminant les copies excessives de données des magasins d'objets des entreprises. Pour ce faire, le logiciel de déduplication compare les données pour trouver les informations en double et ne stocke que les données uniques. Ce processus réduit les coûts de stockage et améliore la gestion des données, ce qui en fait un outil précieux pour toute entreprise désireuse de maîtriser son stockage de données.

La déduplication des données est plus importante que jamais. Les entreprises ont besoin de leurs données pour fonctionner, mais elles doivent également préserver le stockage disponible dans le cloud. La déduplication leur permet de faire les deux.

L'importance de la déduplication des données

La déduplication des données permet aux entreprises d'en faire plus avec leurs données. Les avantages pratiques et les bénéfices de cette technologie innovante sont les suivants :

- Storage Optimization: Storage space can be quite expensive and surprisingly limited. Eliminating duplicate data allows companies to maximize their storage space and reduce overall IT expenses.

- Faster Backup and Restoration: Data deduplication reduces the amount of data companies need to back up and store. Quicker backup and restore processes enable companies to bounce back when their data is corrupted or compromised.

- Bandwidth Optimization: Businesses can use data deduplication to reduce the amount of data they transfer across networks, thus optimizing their bandwidth usage. Companies with multiple offices and remote employees find this aspect of data deduplication especially useful.

- Enhanced Compliance: Data deduplication strengthens data compliance by reducing the amount of unstructured data being stored and managed. Doing so can reduce the risk of data breaches and help companies stick to data protection regulations.

Types de déduplication des données

Il existe deux principaux types de déduplication des données : la déduplication en ligne et le post-traitement. Bien que chacun ait ses propres avantages, de nombreuses entreprises utilisent une combinaison des deux pour répondre à leurs besoins en matière de déduplication des données.

La déduplication en ligne analyse les données pendant le processus de stockage. Lorsque les données sont écrites, le système vérifie si elles sont déjà présentes. Si les données sont dupliquées, un pointeur fait référence aux données d'origine et supprime les redondances. La déduplication en ligne nécessite moins de stockage de sauvegarde, mais elle peut augmenter la latence.

La déduplication post-traitement est un processus de sauvegarde asynchrone qui supprime les données redondantes après qu'elles ont été écrites sur le support de stockage. Les données dupliquées sont extraites et remplacées par un pointeur sur la première itération du bloc. Ce type de déduplication des données permet aux utilisateurs de dédupliquer des charges de travail spécifiques et de récupérer rapidement la sauvegarde la plus récente. Cependant, une plus grande capacité de stockage des sauvegardes est nécessaire par rapport à la déduplication en ligne.

Déduplication au niveau des fichiers ou au niveau des blocs

La déduplication des données peut se faire à deux niveaux : fichier et bloc. Les deux types présentent des avantages et des inconvénients, et la meilleure solution dépend des besoins de l'entreprise. Les entreprises doivent réfléchir à leurs besoins en matière de déduplication des données, évaluer les deux niveaux et mettre en œuvre celui qui répond le mieux à leurs attentes.

La déduplication des données au niveau du fichier compare un ensemble de fichiers à sauvegarder ou à archiver avec des copies déjà stockées. Cette comparaison est effectuée en vérifiant les attributs du fichier par rapport à l'index existant. Si le fichier est considéré comme unique, il est stocké et l'index est mis à jour. Si le fichier n'est pas unique, un pointeur vers le fichier existant est créé et stocké. En fin de compte, une seule instance d'un fichier est sauvegardée. Toutes les copies ultérieures sont remplacées par des pointeurs sur le fichier d'origine.

La déduplication au niveau des blocs examine un fichier et enregistre des itérations uniques de chaque bloc. Les blocs sont divisés en morceaux de longueur fixe, et chaque morceau est traité à l'aide d'un algorithme de hachage. La déduplication au niveau des blocs crée ensuite un numéro unique pour chaque morceau et les stocke dans un index. Ainsi, si un fichier est mis à jour, seules les données modifiées sont sauvegardées. Les modifications apportées au fichier ne créent pas un nouveau fichier distinct. Cette méthode est plus efficace que la déduplication au niveau des fichiers, mais elle nécessite une plus grande puissance de traitement et un index plus important pour garder une trace des différents éléments.

Les défis de la déduplication des données

La déduplication des données peut aider les entreprises à optimiser leurs coûts de stockage et à maximiser leur efficacité, mais elle n'est pas sans poser de problèmes. Pour garantir l'efficacité de la déduplication des données, les entreprises doivent prendre en compte à la fois les avantages et les inconvénients.

- Processing overhead: Deduplication can require considerable processing power, which directly impacts system performance. Overhead can increase when data deduplication requires additional processing power and resources to identify and compare data blocks to check for duplicates. The more data that’s deduplicated, the more processing overhead is required.

- Increased complexity: Since deduplicated data is stored in a non-traditional format, it can be difficult to manage and manipulate. This can cause increased storage complexity. Additionally, metadata is required to track which data blocks are unique and which have been deduplicated. As deduplication increases, managing this metadata becomes even more challenging.

- Data integrity: If not done correctly, data deduplication can compromise data integrity. First, while deduplication decreases the amount of redundant data and improves storage efficiency, the lack of redundancy can make it more difficult to recover data. Second, data deduplication can create an increased risk of data loss because if the metadata used to identify duplicated data is corrupted or lost, deduplicated data will become hard to recover. Lastly, deduplication can result in an increased risk of data corruption. If a corrupted data block is deduplicated, the corruption can spread to other deduplicated data blocks, causing widespread errors or data loss.

- Deduplication ratio: With minimal duplicate data, the duplication ratio will be low. A lower deduplication ratio means less overall storage savings. However, increasing the deduplication ratio can improve storage efficiency, reduce backup times, and reduce network bandwidth requirements.

- Limited Scalability: As we said, deduplication can require significant processing power to identify and compare data blocks. It can negatively impact the scalability of storage and backup infrastructure by slowing down processing times and increasing the risk of data loss. The deduplication ratio can also affect scalability because storage and network bandwidth requirements increase when the ratio is low.

- Enhanced Compliance: Data deduplication strengthens data compliance by reducing the amount of unstructured data being stored and managed. Doing so can reduce the risk of data breaches and help companies stick to data protection regulations.

Shift the balance of power in the fight against ransomware.

Panzura aide les entreprises à dédupliquer leurs données

Panzura CloudFS is a global file system that stops file-level duplication before data is synced to the object store. The file system will store only unique copies of files, so data is deduplicated before it’s even stored. Additionally, Panzura performs inline block-level deduplication on data in the object store. This approach removes duplicate blocks across different files.

Panzura se distingue des autres fournisseurs de déduplication car il intègre la table de référence de déduplication dans des métadonnées qui sont instantanément partagées entre tous les nœuds Panzura . La déduplication en ligne supprime la redondance des données sur tous les nœuds, ce qui permet à chaque nœud de bénéficier des données vues par tous les autres nœuds. Ce processus permet une meilleure réduction de la capacité et garantit que toutes les données dans le nuage sont uniques, ce qui réduit la capacité de stockage et de réseau requise.

La déduplication globale permet à CloudFS de dédupliquer les données redondantes avant qu'elles ne soient déplacées vers le magasin d'objets choisi par l'entreprise. Plutôt que d'examiner des fichiers complets, Panzura examine les blocs individuels qui composent un fichier et les dédoublonne au niveau du bloc. Même si les fichiers dans leur intégralité ne semblent pas identiques, il peut y avoir des blocs de données dupliqués dans ces fichiers. CloudFS permet la déduplication de ces éléments identiques.

Les entreprises qui utilisent CloudFS de Panzurapour la déduplication des données verront leur empreinte de données diminuer de manière significative. Non seulement CloudFS permet cette déduplication, mais il la maintient en permanence en vérifiant les redondances à chaque fois que les données sont déplacées vers le stockage en nuage.

Le stockage dans le nuage est une ressource vitale pour les entreprises modernes, et elles ne devraient pas avoir à lutter pour utiliser cette ressource à son plein potentiel. Nous pensons que les entreprises méritent de conserver toutes leurs données sans avoir à craindre de manquer de stockage. C'est pourquoi Panzura est prêt à aider les organisations de tous types et de toutes tailles à maximiser leur stockage dans le cloud grâce à la déduplication.