Tiempo de lectura: 5 minutos¿Qué es la deduplicación de datos y por qué debería importarle?

La cantidad de datos que producen las empresas crece constantemente, y el ritmo de crecimiento no se está ralentizando. En todo caso, se está acelerando. Pero, ¿qué ocurre con todos esos datos? Con el tiempo, se acumulan y llenan su almacenamiento, ralentizando las operaciones e incurriendo en elevados costes. Si las empresas no encuentran una forma eficaz de gestionar el crecimiento y el almacenamiento de los datos, estos retos no harán más que empeorar. Afortunadamente, la deduplicación de datos ofrece una solución refrescante al crecimiento desenfrenado de los datos.

La deduplicación de datos reduce las necesidades de capacidad de almacenamiento al eliminar las copias excesivas de datos de los almacenes de objetos de las empresas. Para lograrlo, el software de deduplicación compara los datos para encontrar información duplicada y sólo almacena los datos únicos. Este proceso reduce los costes de almacenamiento y mejora la gestión de datos, lo que lo convierte en una herramienta valiosa para cualquier empresa que desee controlar su almacenamiento de datos.

La deduplicación de datos es ahora más crítica que nunca. Las empresas necesitan sus datos para funcionar, pero también necesitan preservar el almacenamiento disponible en la nube. La deduplicación les permite hacer ambas cosas.

La importancia de la deduplicación de datos

La deduplicación de datos permite a las empresas hacer más con sus datos. Entre las ventajas y beneficios prácticos de esta innovadora tecnología se incluyen:

- Optimización del almacenamiento

El espacio de almacenamiento puede ser bastante caro y sorprendentemente limitado. Eliminar los datos duplicados permite a las empresas maximizar su espacio de almacenamiento y reducir los gastos generales de TI.

- Copias de seguridad y restauración más rápidas

La deduplicación de datos reduce la cantidad de datos de los que las empresas tienen que hacer copias de seguridad y almacenar. Los procesos de copia de seguridad y restauración más rápidos permiten a las empresas recuperarse cuando sus datos están dañados o en peligro.

- Optimización del ancho de banda

Las empresas pueden utilizar la deduplicación de datos para reducir la cantidad de datos que transfieren a través de las redes, optimizando así su uso del ancho de banda. Las empresas con múltiples oficinas y empleados remotos encuentran este aspecto de la deduplicación de datos especialmente útil.

La deduplicación de datos refuerza el cumplimiento de la normativa al reducir la cantidad de datos no estructurados que se almacenan y gestionan. Esto puede reducir el riesgo de filtración de datos y ayudar a las empresas a cumplir la normativa de protección de datos.

Tipos de deduplicación de datos

Existen dos tipos principales de deduplicación de datos: en línea y a posteriori. Aunque cada uno tiene sus propias ventajas, muchas empresas utilizan una combinación de ambos para satisfacer sus necesidades de deduplicación de datos.

La deduplicación en línea analiza los datos durante el proceso de almacenamiento. A medida que se escriben los datos, el sistema comprueba si ya están presentes. Si los datos están duplicados, un puntero hace referencia a los datos originales y elimina las redundancias de datos. La deduplicación en línea requiere menos almacenamiento de copia de seguridad, pero puede aumentar la latencia.

La deduplicación postprocesamiento es un proceso de copia de seguridad asíncrono que elimina los datos redundantes después de escribirlos en el almacenamiento. Los datos duplicados se extraen y se sustituyen por un puntero a la primera iteración del bloque. Este tipo de deduplicación de datos permite a los usuarios deduplicar cargas de trabajo específicas y recuperar rápidamente la copia de seguridad más reciente. Sin embargo, se requiere una mayor capacidad de almacenamiento de copias de seguridad en comparación con la deduplicación en línea.

Deduplicación a nivel de archivos frente a deduplicación a nivel de bloques

La deduplicación de datos puede producirse a dos niveles: archivo y bloque. Ambos tipos ofrecen ventajas e inconvenientes, y la mejor solución depende de las necesidades de la organización. Las empresas deben considerar sus necesidades de deduplicación de datos, evaluar los dos niveles e implantar el que cumpla todos los requisitos.

La deduplicación de datos a nivel de fichero compara un conjunto de ficheros que se va a copiar o archivar con copias ya almacenadas. Esta comparación se realiza cotejando los atributos del fichero con el índice existente. Si el archivo se considera único, se almacena y se actualiza el índice. Si el fichero no es único, se crea y almacena un puntero al fichero existente. En última instancia, sólo se guarda una instancia de un fichero. Todas las copias posteriores se sustituyen por stubs que apuntan al fichero original.

La deduplicación por bloques examina un archivo y guarda iteraciones únicas de cada bloque. Los bloques se dividen en trozos con una longitud fija, y cada trozo se procesa mediante un algoritmo hash. A continuación, la deduplicación por bloques crea un número único para cada trozo y los almacena en un índice. Así, si se actualiza un archivo, sólo se guardan los datos modificados. Los cambios en el archivo no crean un nuevo archivo independiente. Este método es más eficaz que la deduplicación a nivel de archivo, pero requiere más capacidad de procesamiento y un índice mayor para realizar el seguimiento de las piezas individuales.

Desafíos de la deduplicación de datos

La deduplicación de datos refuerza el cumplimiento de la normativa al reducir la cantidad de datos no estructurados que se almacenan y gestionan. Esto puede reducir el riesgo de filtración de datos y ayudar a las empresas a cumplir la normativa de protección de datos.

La deduplicación de datos puede ser decisiva para ayudar a las empresas a optimizar sus costes de almacenamiento y maximizar su eficiencia, pero no está exenta de dificultades. Para garantizar la eficacia de la deduplicación de datos, las empresas deben tener en cuenta tanto las ventajas como los retos.

- Gastos generales de procesamiento

La deduplicación puede requerir una potencia de procesamiento considerable, lo que repercute directamente en el rendimiento del sistema. La sobrecarga puede aumentar cuando la deduplicación de datos requiere potencia de procesamiento y recursos adicionales para identificar y comparar bloques de datos para comprobar si hay duplicados. Cuantos más datos se dedupliquen, más sobrecarga de procesamiento se requerirá.

Dado que los datos deduplicados se almacenan en un formato no tradicional, puede resultar difícil gestionarlos y manipularlos. Esto puede aumentar la complejidad del almacenamiento. Además, se necesitan metadatos para saber qué bloques de datos son únicos y cuáles se han deduplicado. A medida que aumenta la deduplicación, la gestión de estos metadatos se convierte en un reto aún mayor.

Si no se hace correctamente, la deduplicación de datos puede poner en peligro la integridad de los datos. En primer lugar, aunque la deduplicación reduce la cantidad de datos redundantes y mejora la eficiencia del almacenamiento, la falta de redundancia puede dificultar la recuperación de los datos. En segundo lugar, la deduplicación de datos puede crear un mayor riesgo de pérdida de datos, ya que si los metadatos utilizados para identificar los datos duplicados se corrompen o se pierden, los datos deduplicados serán difíciles de recuperar. Por último, la deduplicación puede aumentar el riesgo de corrupción de datos. Si se deduplica un bloque de datos corrupto, la corrupción puede propagarse a otros bloques de datos deduplicados, provocando errores generalizados o la pérdida de datos.

Con un mínimo de datos duplicados, el ratio de duplicación será bajo. Un ratio de deduplicación más bajo implica un menor ahorro global de almacenamiento. Sin embargo, aumentar el ratio de deduplicación puede mejorar la eficiencia del almacenamiento, reducir los tiempos de copia de seguridad y reducir los requisitos de ancho de banda de la red.

Como hemos dicho, la deduplicación puede requerir una potencia de procesamiento considerable para identificar y comparar bloques de datos. Puede afectar negativamente a la escalabilidad de la infraestructura de almacenamiento y copia de seguridad al ralentizar los tiempos de procesamiento y aumentar el riesgo de pérdida de datos. El ratio de deduplicación también puede afectar a la escalabilidad porque los requisitos de almacenamiento y ancho de banda de red aumentan cuando el ratio es bajo.

La deduplicación de datos refuerza el cumplimiento de la normativa al reducir la cantidad de datos no estructurados que se almacenan y gestionan. Esto puede reducir el riesgo de filtración de datos y ayudar a las empresas a cumplir la normativa de protección de datos.

Shift the balance of power in the fight against ransomware.

Panzura ayuda a las empresas a deduplicar sus datos

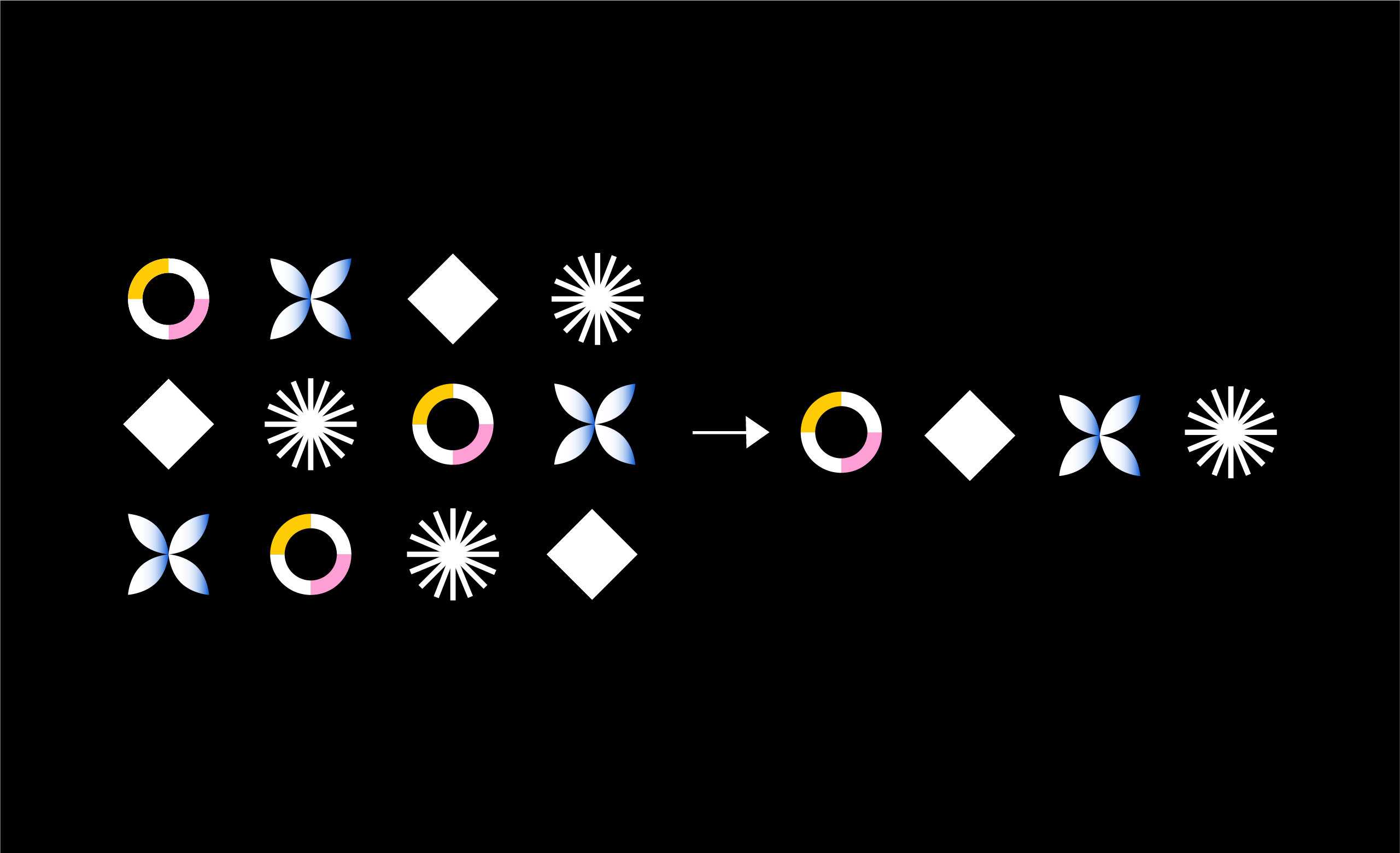

Panzura CloudFS es un sistema de archivos global que detiene la duplicación a nivel de archivo antes de que los datos se sincronicen con el almacén de objetos. El sistema de archivos sólo almacena copias únicas de los archivos, por lo que los datos se deduplican incluso antes de ser almacenados. Además, Panzura realiza una deduplicación en línea a nivel de bloque en los datos del almacén de objetos. Este método elimina los bloques duplicados en distintos archivos.

Panzura se distingue de otros proveedores de deduplicación porque incorpora la tabla de referencia de deduplicación en metadatos que se comparten instantáneamente entre todos los nodos de Panzura . La deduplicación en línea elimina la redundancia de datos en todos los nodos, lo que permite que cada nodo se beneficie de los datos vistos por todos los demás nodos. Este proceso proporciona una mejor reducción de la capacidad y garantiza que todos los datos de la nube son únicos, lo que reduce la capacidad de almacenamiento y de red necesaria en la nube.

La deduplicación global permite a CloudFS deduplicar los datos redundantes antes de trasladarlos al almacén de objetos elegido por la empresa. En lugar de examinar archivos completos, Panzura examina los bloques individuales que componen un archivo y los deduplica a nivel de bloque. Aunque los archivos en su totalidad no parezcan idénticos, puede haber bloques de datos duplicados dentro de esos archivos. CloudFS permite la deduplicación de esos elementos idénticos.

Las empresas que utilicen CloudFS de Panzurapara la deduplicación de datos experimentarán una reducción significativa de su huella de datos. CloudFS no solo permite esta deduplicación, sino que la mantiene en todo momento comprobando si hay redundancias cada vez que los datos se trasladan al almacenamiento en la nube.

El almacenamiento en la nube es un recurso vital para las empresas modernas, y no deberían tener que esforzarse por utilizar ese recurso en todo su potencial. Creemos que las empresas merecen conservar todos sus datos sin vivir con el temor de quedarse sin almacenamiento. Por eso Panzura está preparado para ayudar a organizaciones de todo tipo y tamaño a maximizar su almacenamiento en la nube mediante la deduplicación.